Ce qu’il faut retenir : l’A/B testing ne se contente pas de comparer deux versions, il transforme les opinions subjectives en décisions basées sur la donnée. Cette approche rigoureuse fluidifie le parcours client tout en sécurisant le chiffre d’affaires. Avec 75 % des gros sites l’utilisant, c’est le levier incontournable pour une croissance maîtrisée.

Vous en avez assez de piloter votre site à l’aveugle en vous basant sur de simples intuitions ? L’a/b testing vous permet de trancher enfin par la data pour offrir une expérience utilisateur irréprochable. Découvrez les méthodes concrètes pour valider vos choix et booster durablement votre rentabilité. ????

- L’a/b testing, c’est quoi au juste ?

- Pourquoi s’embêter avec l’A/B testing ? Les vrais bénéfices

- Construire une stratégie de test qui tient la route

- Les suspects habituels : quoi tester sur votre site ?

- Les statistiques sans se prendre la tête

- Les erreurs classiques qui ruinent vos tests

- Aller plus loin : les différents types de tests

L’a/b testing, c’est quoi au juste ?

L’A/B testing est une méthode d’optimisation digitale qui consiste à comparer deux versions d’un élément pour identifier la plus performante. Cette approche permet de prendre des décisions basées sur des données concrètes et d’améliorer continuellement l’expérience utilisateur et le retour sur investissement.

Définition sans jargon

L’A/B testing, ou test fractionné, est une expérience d’une simplicité redoutable. On prend un élément précis, comme un bouton sur votre site. On en crée ensuite deux versions distinctes.

On montre la version A à une moitié des visiteurs. L’autre moitié voit la version B, sans le savoir.

Ensuite, on regarde les chiffres pour voir quelle version a le mieux fonctionné. C’est une méthode radicale pour prendre des décisions basées sur des preuves concrètes. Fini les suppositions hasardeuses qui coûtent cher.

Le principe de base : une version A, une version B

La version « A » est votre version de contrôle. C’est l’original, ce qui existe déjà sur votre page actuelle. Pensez-y comme le champion en titre à battre. Elle sert de point de référence indispensable pour mesurer la performance réelle.

La version « B » est la variante, le challenger ambitieux. C’est là qu’on introduit un seul changement stratégique. Un nouveau titre percutant, une couleur différente ou une autre image.

Le trafic est réparti aléatoirement entre les deux. C’est la clé absolue de la fiabilité statistique.

L’objectif : arrêter de deviner

Le but premier est de sortir du débat d’opinions stérile. Fini les « je pense que » ou « j’aime mieux cette version » en réunion. Seules les données froides comptent désormais.

L’A/B testing fournit des preuves tangibles sur ce que vos utilisateurs préfèrent réellement. Leurs actions parlent bien plus fort que n’importe quelle intuition marketing, même celle du patron. C’est la réalité du terrain.

On cherche la version qui atteint le mieux un objectif précis. Par exemple, obtenir le plus de clics ou de ventes.

Plus qu’un test, une culture de l’expérimentation

Adopter l’A/B testing, c’est accepter humblement que l’on ne sait pas tout. C’est une posture d’humilité nécessaire face au comportement imprévisible des utilisateurs. On laisse le marché décider.

Cela encourage une mentalité d’amélioration continue au sein des équipes. Chaque test, qu’il soit gagnant ou perdant, est un apprentissage précieux. On ne perd jamais, on apprend toujours quelque chose sur son audience.

Les géants comme Netflix ou Booking testent en permanence. C’est intégré à leur ADN pour rester leaders.

Pourquoi s’embêter avec l’A/B testing ? Les vrais bénéfices

Maintenant que les bases du split testing sont posées, une question légitime surgit : pourquoi investir du temps là-dedans ? Au-delà de la « hype » technique, voyons ce que votre entreprise gagne vraiment à comparer deux versions.

Des décisions basées sur des faits, pas des intuitions

Fini les débats stériles où celui qui parle le plus fort gagne. Le principal atout est de chiffrer l’impact d’un changement. Vous ne devinez plus, vous mesurez concrètement. C’est la fin des guerres d’ego en réunion.

Chaque décision de modification sur votre site ou votre produit peut être validée par le comportement réel des utilisateurs. On remplace les « je pense que » par des preuves statistiques irréfutables.

Cela permet de construire une stratégie digitale solide et justifiable. Les chiffres sont vos meilleurs alliés.

Améliorer l’expérience utilisateur pour de vrai

En testant différentes approches, on identifie les frictions dans le parcours client. Un bouton mal placé, un formulaire trop long, un message peu clair. L’A/B testing les met en lumière. Vous voyez le problème immédiatement.

L’objectif est de rendre la navigation plus fluide et agréable. Un utilisateur content est un utilisateur qui revient et qui convertit bien plus facilement.

C’est un levier direct pour améliorer l’importance de l’expérience utilisateur.

Augmenter le retour sur investissement (ROI)

C’est le nerf de la guerre. L’A/B testing a un impact direct sur vos indicateurs business. Taux de conversion, revenus, inscriptions.

Une petite amélioration du taux de conversion sur une page à fort trafic peut se traduire par des milliers d’euros de revenus supplémentaires. Vous arrêtez de laisser de l’argent sur la table.

Chaque test réussi est un pas de plus vers une meilleure rentabilité de vos actions marketing.

Mieux comprendre ses clients et réduire les risques

Chaque test révèle une préférence de votre audience. Vous apprenez ce qui les motive, ce qui les freine.

C’est une mine d’or pour affiner vos personas.

Voici les impacts concrets sur votre activité :

- Réduction des risques : Tester une nouvelle fonctionnalité à petite échelle avant un déploiement complet évite les catastrophes.

- Amélioration continue : Chaque test alimente une boucle d’apprentissage pour des performances toujours meilleures.

- Meilleure connaissance client : Comprendre les préférences réelles de votre audience au-delà des sondages.

Construire une stratégie de test qui tient la route

Ok, les bénéfices sont clairs. Mais l’A/B testing n’est pas une baguette magique qui résout tout instantanément. Pour que ça marche vraiment, il faut une approche structurée, un véritable plan de bataille.

L’audit de départ : où sont les points de friction ?

Tout commence par une observation lucide de la réalité. Avant de tester quoi que ce soit, vous devez identifier les points de rupture. À quelle étape précise vos prospects abandonnent-ils leur panier pour partir ?

Repérez vite les pages affichant un taux de rebond anormalement élevé. C’est la première étape indispensable : traquer les faiblesses techniques ou visuelles qui font fuir votre audience.

Définissez ensuite un objectif cristallin pour avancer. Vous devez vouloir augmenter les clics, les inscriptions ou les ventes.

Mesurer et analyser : les données avant tout

Une fois les zones de friction repérées, il faut creuser. Les données quantitatives, comme Google Analytics, vous disent « où » est le problème. Les données qualitatives, via heatmaps et enregistrements, vous disent « pourquoi » cela arrive vraiment.

C’est cette combinaison unique qui permet de saisir le comportement utilisateur. Ne vous contentez jamais des chiffres bruts, ils ne racontent qu’une moitié de l’histoire.

C’est la base pour utiliser les données analytics pour améliorer vos stratégies.

L’art de formuler une bonne hypothèse

Une hypothèse n’est pas une simple idée lancée en l’air. Elle doit être précise, chiffrée et mesurable. Elle relie directement un changement spécifique à un résultat attendu.

Prenez cet exemple concret : « En ajoutant du texte explicatif à côté des icônes de navigation, nous pensons augmenter le taux de clics de 15 % ». C’est une prédiction claire et vérifiable.

C’est votre seul véritable fil conducteur. Sans une hypothèse de départ parfaitement claire, le test reste totalement inutile.

Prioriser les tests pour un impact maximal

Vous aurez vite une liste interminable d’idées de tests à lancer. Il est impossible de tout faire simultanément. Il faut donc choisir ses batailles avec un grand soin.

Des cadres reconnus comme le modèle PIE (Potentiel, Impact, Facilité) aident à noter chaque idée. On se concentre alors uniquement sur les tests à fort potentiel et faciles à mettre en place.

Cela permet de créer une feuille de route cohérente. On s’attaque d’abord à ce qui compte le plus.

Les suspects habituels : quoi tester sur votre site ?

La stratégie est en place. Maintenant, passons au concret. Quels sont les éléments que l’on peut, et que l’on doit, mettre sur le gril ?

Les appels à l’action (cta) et les titres

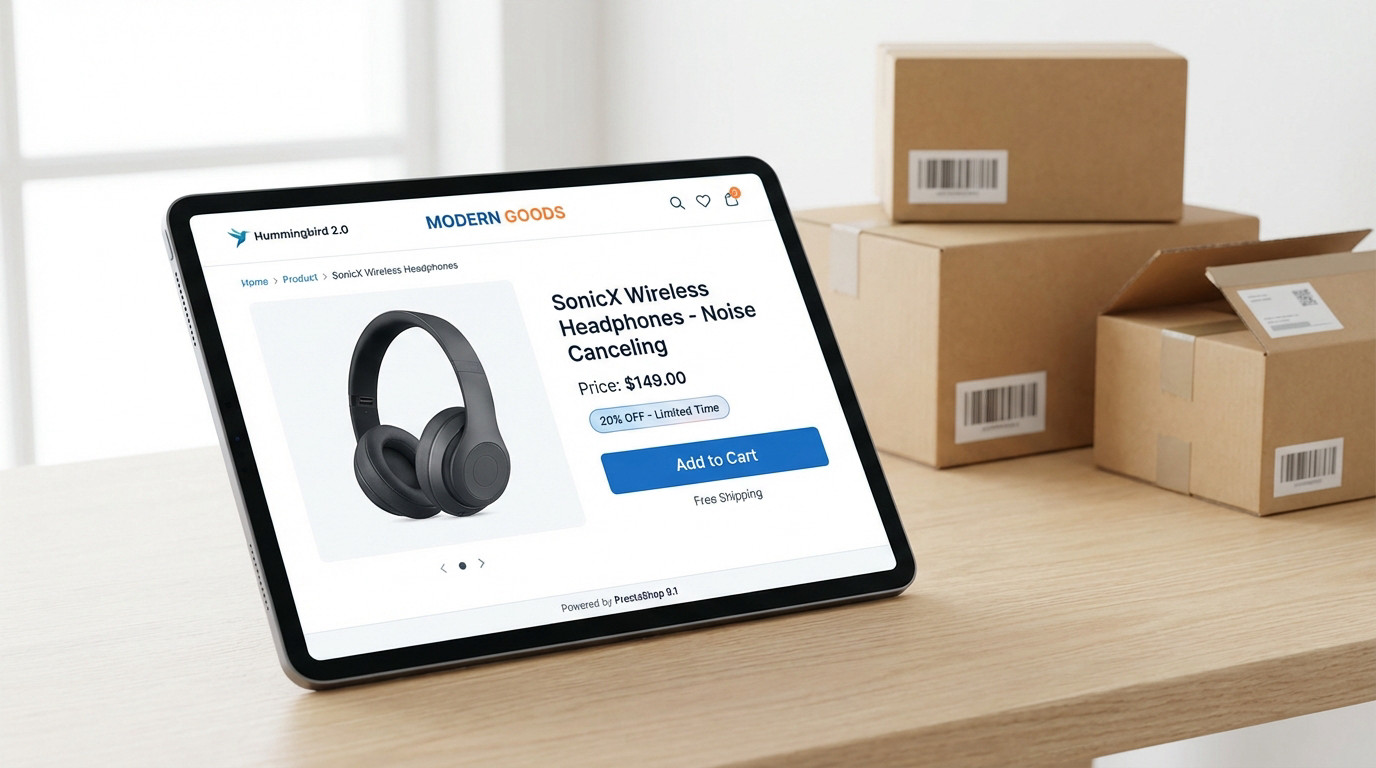

Le bouton d’appel à l’action est un candidat parfait. Changer son texte, par exemple « Acheter » contre « Ajouter au panier », sa couleur, sa taille ou sa position peut tout changer. C’est souvent là que ça coince.

Les titres sont la première chose que les gens lisent. Un titre plus percutant ou plus clair peut radicalement modifier l’engagement. Vous risquez de perdre l’attention du lecteur si cette accroche est ratée.

Ce sont des tests à gain rapide. L’impact est souvent direct et facile à mesurer pour vos équipes.

Le design et la mise en page

La structure d’une page influence énormément le parcours de l’utilisateur. Faut-il une seule colonne ou plusieurs ? C’est une question de fluidité qui mérite d’être posée pour ne pas perdre le visiteur en route.

On peut tester l’ordre des blocs, la présence ou non d’une barre latérale, ou même une refonte complète de la page d’accueil. Parfois, il faut oser bousculer l’existant pour voir ce qui fonctionne vraiment.

Ces tests sont plus complexes mais peuvent apporter des gains spectaculaires. Le jeu en vaut la chandelle.

Les images, vidéos et autres visuels

L’humain est visuel. Tester l’image principale d’une page produit peut avoir un effet énorme. Une photo d’ambiance contre une photo produit sur fond blanc ? Un visuel avec une personne ou sans ? Les résultats surprennent souvent.

Même chose pour les vidéos. Leur miniature, leur longueur ou leur positionnement sur la page sont des variables à tester. Ne laissez pas ces éléments au hasard, ils captent l’attention immédiatement.

L’impact émotionnel d’un visuel est un levier puissant.

Le contenu et le wording

Les mots ont un poids. Le ton utilisé dans vos textes, la longueur des paragraphes, la formulation des avantages… Chaque nuance compte pour convaincre et transformer un simple visiteur en client fidèle.

Tout peut être testé pour trouver la bonne formule.

Voici les éléments clés à surveiller :

- Titres et sous-titres : Pour capter l’attention.

- Boutons d’appel à l’action (CTA) : Le texte, la couleur, la forme.

- Mises en page : La disposition des éléments sur une page.

- Images et vidéos : Les visuels utilisés pour illustrer un produit ou un service.

- Formulaires : Le nombre de champs, leur libellé.

Les statistiques sans se prendre la tête

On sait quoi tester. Mais le cœur de l’A/B testing, c’est l’analyse. Et qui dit analyse, dit statistiques. Pas de panique, on peut comprendre les bases sans être un mathématicien.

La significativité statistique, le juge de paix

C’est le concept le plus important de votre analyse. La significativité statistique vous dit si le résultat de votre test est vraiment dû à votre changement, ou simplement au hasard. C’est une mesure de confiance indispensable. Elle valide la fiabilité de vos données.

Un résultat est considéré « statistiquement significatif » si la probabilité qu’il soit le fruit du hasard reste très faible. On utilise souvent la p-value pour le vérifier. C’est votre baromètre de vérité.

Sans ça, votre conclusion ne vaut rien. Vous ne faites que deviner au hasard.

Le niveau de confiance : 95 % ou plus ?

Le plus souvent, on vise un niveau de confiance de 95% pour valider un test. Cela veut dire qu’il y a 95% de chances que le résultat soit correct, et 5% de chances que ce soit le hasard.

Pour des décisions à fort enjeu financier, on peut viser 99%. Mais cela demande beaucoup plus de trafic et de temps de test. C’est un investissement lourd.

Le seuil de 95% est un standard de l’industrie. C’est un bon équilibre entre rigueur et pragmatisme.

Approche fréquentiste vs bayésienne : deux écoles

La méthode fréquentiste est la plus classique en statistiques. Elle demande de fixer la durée du test à l’avance et donne un verdict à la fin. C’est une approche rigide.

L’approche bayésienne est bien plus souple pour les équipes agiles. Elle donne une probabilité de gain en temps réel et permet de prendre des décisions plus rapidement. C’est un atout majeur pour l’itération.

La plupart des outils modernes tendent vers l’approche bayésienne. Elle reste bien plus intuitive pour les marketeurs.

A/b testing vs anova : quand simple suffit

L’ANOVA est une méthode statistique bien plus complexe. Elle sert à comparer plus de deux variantes ou plusieurs variables en même temps. C’est utile pour les tests lourds.

Pour comparer une version A à une version B, l’A/B testing classique est parfaitement adapté. C’est l’outil de base, simple et efficace, pour vos besoins courants. Pas besoin de sortir l’artillerie lourde.

Il est souvent inutile de trop compliquer les choses. L’important est de bien faire les bases avant tout.

Les erreurs classiques qui ruinent vos tests

La théorie, c’est bien beau. Mais sur le terrain, de nombreux pièges attendent les équipes qui se lancent. Connaître les erreurs les plus courantes est le meilleur moyen de les éviter.

Arrêter le test trop tôt : le piège de l’impatience

C’est l’erreur numéro un des débutants. Une variante B semble décoller après deux jours, alors on coupe tout. C’est une très mauvaise idée qui vous coûtera cher sur le long terme.

Les premiers résultats sont souvent trompeurs à cause de la variance naturelle. Il faut attendre d’atteindre la significativité statistique de 95 % et un échantillon de visiteurs suffisant pour valider la donnée.

La patience est une vertu en A/B testing. Laissez tourner le test assez longtemps pour lisser les fluctuations.

Tester trop de choses à la fois

Si votre version B modifie simultanément le titre, l’image et le bouton d’appel à l’action, comment saurez-vous ce qui a réellement performé ? C’est impossible. Vous n’apprenez rien sur les motivations profondes de vos visiteurs.

La règle d’or de l’A/B testing est stricte : un seul changement par test. C’est le seul moyen d’isoler l’impact précis de ce changement sur vos conversions.

Pour tester plusieurs changements complexes, il faut lancer un test multivarié.

Ignorer les effets externes comme la saisonnalité

Le comportement de vos utilisateurs n’est pas le même un lundi matin et un samedi soir. Ni en juillet et en décembre. Vos taux de conversion varient naturellement selon le moment.

Un test doit durer au moins une semaine complète pour lisser ces variations cycliques. Pour des business saisonniers, il faut être encore plus prudent et couvrir un cycle de vente entier.

Le contexte temporel de votre test est tout aussi important que le test lui-même pour la fiabilité.

Changer les règles en cours de route

Vous avez défini une hypothèse et un indicateur clé (KPI) au début. Ne les changez pas en cours de test pour valider vos biais. Restez rigoureux jusqu’au bout.

C’est une forme de triche intellectuelle qui biaise tout.

Voici les pièges qui faussent vos données :

- Arrêt prématuré : Stopper un test dès qu’une version semble gagner, sans attendre la significativité statistique.

- Multiplication des variantes : Changer trop d’éléments à la fois, ce qui empêche de savoir ce qui a fonctionné.

- Oubli des effets saisonniers : Ne pas tenir compte des variations de trafic et de comportement liées au calendrier.

- Changement de KPI : Modifier l’indicateur de succès en plein milieu du test pour « trouver » un gagnant.

Aller plus loin : les différents types de tests

L’A/B testing classique, c’est la base, mais ce n’est pas l’unique option. Pour vraiment optimiser vos performances, il faut connaître toute la famille de l’expérimentation digitale.

Le test a/b/n : quand deux options ne suffisent pas

C’est une extension logique du format classique. Au lieu de vous limiter à un duel A contre B, vous lancez A, B, C voire D dans l’arène. Ici, « n » représente simplement le nombre total de variantes concurrentes.

Cette méthode brille quand vous hésitez entre trois titres accrocheurs ou quatre visuels distincts. Vous les testez tous simultanément pour ne pas perdre de temps. C’est radical pour trancher rapidement entre plusieurs bonnes idées.

Le principe fondateur reste identique malgré la multiplication des pistes. Un seul élément change entre chaque version proposée.

Le test multivarié : pour les plus audacieux

Ici, on change la donne en modifiant plusieurs éléments à la fois. Imaginez tester deux titres percutants ET trois images de fond différentes. Votre outil générera automatiquement les six combinaisons possibles pour les soumettre aux visiteurs.

L’atout majeur réside dans la précision chirurgicale de l’analyse. Vous mesurez l’impact isolé de chaque composant, mais aussi comment ils interagissent ensemble. C’est une mine d’or d’informations pour comprendre votre audience.

Mais attention, cette puissance a un coût élevé. Il vous faut impérativement un trafic massif.

Le test fractionné (split testing) : une question de sémantique ?

On entend souvent « A/B testing » et « split testing » utilisés comme des synonymes parfaits. Dans 95 % des conversations marketing, cette confusion ne pose aucun problème. C’est même techniquement acceptable pour la majorité des cas.

Pourtant, les puristes noteront qu’un vrai « split test » héberge souvent les variantes sur des URLs distinctes. C’est la méthode privilégiée pour comparer deux pages radicalement différentes, comme lors d’une refonte totale de design.

Dans la pratique quotidienne, ne vous bloquez pas sur cette nuance technique. L’objectif de comparaison reste strictement le même.

Choisir le bon type de test pour le bon problème

Commencez systématiquement par l’A/B testing classique pour vos premières armes. C’est le chemin le plus court et le moins risqué pour obtenir des gains concrets. Vous apprendrez vite sans complexité inutile.

Si vous avez plusieurs hypothèses solides pour un même bouton, passez naturellement au test A/B/n. C’est l’évolution logique quand votre créativité dépasse le simple choix binaire. Vous gagnerez un temps précieux sur vos itérations.

Réservez le test multivarié aux sites générant un trafic colossal. C’est un outil puissant, mais extrêmement exigeant en données.

L’A/B testing est bien plus qu’une simple technique : c’est le carburant de votre croissance digitale. En remplaçant les suppositions par des preuves concrètes, vous offrez une expérience utilisateur irréprochable tout en boostant votre ROI. Ne craignez pas l’échec, car chaque test est une leçon. Lancez-vous et faites enfin parler vos données ! ????